在当今复杂的网络环境和大规模的系统架构中,负载均衡起着至关重要的作用。它能够优化资源分配、提高系统性能与可靠性,确保服务的稳定运行。

负载均衡有多种分类方式,从实现方式来看,分为硬件负载均衡和软件负载均衡;按负载均衡层次可分为二层、三层、四层和七层负载均衡;按位置可分为服务端负载均衡和客户端负载均衡。了解这些分类有助于我们根据实际需求选择最适合的负载均衡方案,为构建高效、稳定的系统架构奠定基础。

按实现方式分类

硬件负载均衡

指通过专门的硬件设备实现负载均衡功能。这些设备内部有高性能的处理器和专用芯片,用于处理网络数据包的解析和转发。如 F5 硬件负载均衡器(通常指 F5 Big-IP 系列产品),它们在硬件层面优化了网络处理能力,能高效地处理大量并发请求。

🔳性能特点

具有高性能和高吞吐量,能够快速地分配大量请求,且网络延迟较低。其稳定性和可靠性较高,经过严格的硬件测试和质量认证,能长时间稳定工作。不过,硬件负载均衡器价格昂贵,且设备升级可能比较复杂,需要专业的技术支持。

🔳应用场景

适用于对性能、稳定性和安全性要求极高的大型企业数据中心、云计算服务提供商和金融机构等场景。例如,在银行的网上交易系统中,硬件负载均衡器可以确保大量交易请求快速、稳定地分配到后端服务器。

软件负载均衡

指基于软件程序在通用服务器上实现负载均衡。软件利用服务器的 CPU、内存等硬件资源来处理请求的接收、分配和转发。例如,Nginx 和 HAProxy 是常见的软件负载均衡工具,它们通过在服务器操作系统上安装和配置相应软件来发挥作用。

🔳性能特点

软件负载均衡具有灵活性高的特点,可以根据具体需求进行定制化配置。成本相对较低,因为它主要依靠软件安装在普通服务器上。但它的性能可能受服务器硬件资源限制,在处理极高并发请求时,可能会出现性能瓶颈。

🔳应用场景

广泛应用于中小规模的互联网企业、创业公司和内部网络系统。例如,在一个小型电商网站中,使用软件负载均衡器可以有效地将用户请求分配到后端的 Web 服务器和应用服务器上。

spring cloud 广告位

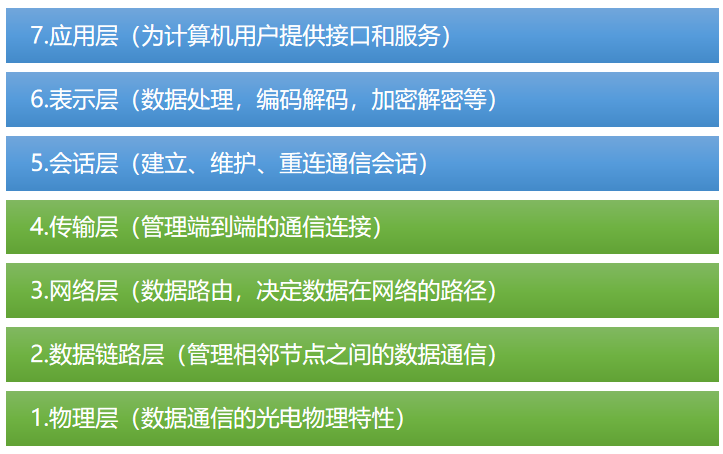

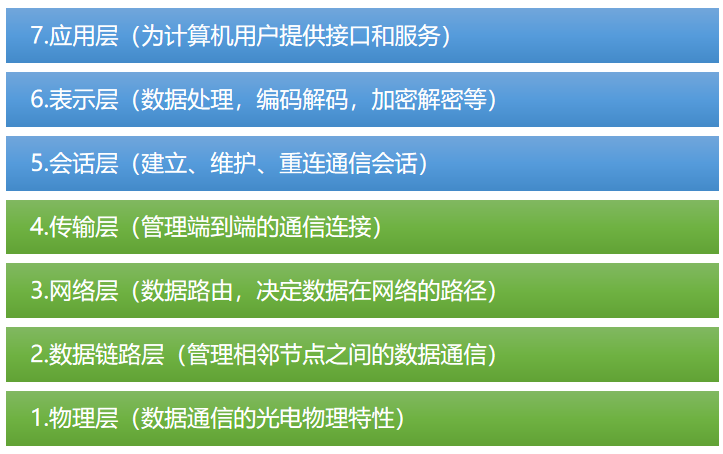

按负载均衡层次分类

二层(数据链路层)负载均衡

该负载均衡器工作在 OSI 七层参考模型的数据链路层,主要基于 MAC 地址进行负载分配。负载均衡器会修改数据包的 MAC 地址,将请求转发到后端服务器。它通常会维护一个 MAC 地址表,用于记录服务器的 MAC 地址和对应的链路状态。

🔳性能特点

处理速度相对较快,因为它不需要解析高层协议。但它对网络拓扑结构的依赖性较强,并且功能相对有限,主要用于简单的网络流量分配。

🔳应用场景

适用于小型的、基于局域网的服务器集群负载均衡,例如在一个企业内部的文件共享服务器集群中,可以使用二层负载均衡来分配文件访问请求。

三层(网络层)负载均衡

在网络层工作,基于 IP 地址和端口进行负载分配。通过网络地址转换(NAT)技术,将客户端请求的目标 IP 地址(虚拟 IP)转换为后端服务器的真实 IP 地址,实现请求的转发。例如,在数据中心入口处,三层负载均衡器可以根据 IP 数据包的目的 IP 地址和端口号来分配流量。

🔳性能特点

性能较高,不需要解析高层协议(如传输层和应用层协议),所以处理速度快。通用性强,对于不同的应用层协议,只要是基于 IP 的网络通信都可以进行负载均衡。但缺乏应用层感知,无法根据应用层的具体内容进行精细的负载分配。

🔳应用场景

常用于网络流量入口处的负载均衡,如企业数据中心或互联网服务提供商(ISP)的网络架构中,将来自外部网络的大量请求均衡地分配到内部的服务器集群。

四层(传输层)负载均衡

在传输层工作,主要基于 TCP(传输控制协议)和 UDP(用户数据报协议)协议进行负载分配。根据 TCP 或 UDP 数据包的目标端口号、源 IP 地址等信息来分配负载,对于 TCP 协议还会维护连接状态。例如,当客户端发起一个 TCP 连接请求时,四层负载均衡器会根据算法(如最少连接、加权最少连接等)将该连接请求分配到后端的服务器。

🔳性能特点

具有协议通用性与高效性结合的特点,既可以处理 TCP 和 UDP 协议相关的流量,又能深入到传输层进行高效的连接分配。对应用层相对透明,只要是基于 TCP 或 UDP 的应用都可以进行负载均衡,但有限的应用层感知能力,不能像七层负载均衡那样深入到应用层协议的具体内容进行精细的负载分配。

🔳应用场景

适用于各种基于 TCP 或 UDP 的网络服务,如 HTTP、HTTPS(基于 TCP)、DNS、SNMP(基于 UDP)等协议的负载均衡,以及云计算和数据中心内部服务分配。

七层(应用层)负载均衡

在应用层工作,会深入解析应用层协议的具体内容来进行负载分配。以 HTTP/HTTPS 协议为例,会查看请求的 URL 路径、请求头中的信息(如用户代理、Cookie 等)、请求方法(GET、POST 等),然后根据这些内容,按照预先配置的规则进行负载分配。例如,根据请求的 URL 将不同类型的业务请求分配到专门的服务器组。

🔳性能特点

能够进行精细的应用层负载分配,根据应用层协议的详细内容将不同类型的业务请求分配到最适合处理该业务的服务器组,提高资源的利用效率。可以优化用户体验,通过对应用层内容的感知,更好地适应不同的用户需求,但会带来一定的性能开销,因为需要解析应用层协议的内容。

🔳应用场景

广泛应用于复杂的 Web 应用和 API 服务,如电商、社交网络、内容管理系统等的负载均衡,以及各种应用程序接口(API)服务的负载均衡。

spring cloud 广告位

按负载均衡位置分

客户端负载均衡

是指负载均衡的逻辑集成在客户端应用程序内部。客户端维护着一个服务器列表(通过服务发现机制获取,也可以从配置文件中读取),在发起请求时,根据一定的算法(如轮询、随机、加权等)直接选择要访问的服务器。例如,在一个分布式微服务架构中,服务消费者(客户端)在自己的代码中嵌入负载均衡逻辑,从多个服务提供者(服务器)中选择一个来发送请求。

🔳工作流程

(1)客户端应用启动时,通过服务发现组件获取后端服务器列表。

(2)当需要发送请求时,客户端根据负载均衡算法从列表中选择一个服务器。

(3)客户端直接将请求发送到选定的服务器,服务器处理请求后将响应直接返回给客户端。

🔳优点

高度定制化:客户端可以根据自身的业务逻辑和性能需求,灵活地定制负载均衡算法。比如,根据不同用户的优先级或请求类型,采用不同的选择策略。

减少网络延迟:由于请求直接从客户端发送到目标服务器,不需要经过额外的负载均衡器转发,减少了网络跳数,可能会降低网络延迟。在对网络延迟敏感的应用场景(如实时数据传输)中,这是一个重要的优势。

更好的故障处理能力:客户端可以更及时地感知服务器的故障状态。一旦发现某个服务器无法响应,客户端可以立即将其从可用服务器列表中移除,避免向故障服务器发送请求。

🔳缺点

增加客户端复杂性:需要在客户端代码中集成负载均衡逻辑,增加了客户端应用程序的复杂性和开发难度。这可能导致代码的维护成本增加,并且要求开发人员对负载均衡和网络通信有更深入的理解。

更新和管理困难:当服务器列表发生变化(如添加或删除服务器)或者负载均衡策略需要调整时,需要更新所有的客户端应用程序。在大规模的分布式系统中,这可能是一个繁琐且容易出错的过程。

资源消耗:客户端需要消耗额外的资源(如内存和 CPU)来维护服务器列表和执行负载均衡算法。对于资源受限的客户端设备(如移动设备),这可能会影响其性能。

🔳应用场景

微服务架构中的服务调用:在微服务架构中,服务消费者(客户端)频繁调用多个服务提供者,且对性能和定制化要求较高的场景。例如,在一个电商微服务系统中,订单服务作为客户端调用库存服务、用户服务等,通过客户端负载均衡可以根据业务规则灵活分配请求。

对网络延迟敏感的应用:如实时数据传输系统、高频金融交易系统等,需要减少网络延迟,直接从客户端选择服务器可以更快地将请求发送到目标服务器。

资源受限的客户端设备:当客户端设备本身资源有限,如移动设备,但又需要一定的负载均衡功能时,可以在客户端应用中集成轻量级的负载均衡逻辑,根据设备的性能和网络状况选择合适的服务器。

服务端负载均衡

在服务器端设置一个独立的负载均衡器。客户端将请求发送到这个负载均衡器,负载均衡器根据预设的算法(如轮询、加权轮询、最少连接等)将请求分配到后端的服务器。例如,在一个 Web 应用中,用户通过浏览器访问网站,请求先到达负载均衡器,然后由负载均衡器将请求分配到后端的 Web 服务器。

🔳工作流程

(1)客户端发送请求到服务端负载均衡器的 IP 地址和端口。

(2)负载均衡器接收请求,根据负载均衡算法和后端服务器的状态选择一个后端服务器。

(3)负载均衡器将请求转发到选定的后端服务器,后端服务器处理请求后将响应返回给负载均衡器,再由负载均衡器将响应返回给客户端。

🔳优点

集中管理和控制:负载均衡策略的配置和调整都在负载均衡器上进行,方便集中管理。管理员可以轻松地添加、删除服务器,或者修改负载均衡算法,而不需要修改客户端应用程序。

透明性:对客户端来说是透明的,客户端不需要知道后端服务器的具体情况,只需要将请求发送到负载均衡器即可。这使得系统的维护和扩展对客户端没有影响,提高了系统的可维护性。

安全性和监控能力:负载均衡器可以作为一个安全防护层,过滤恶意请求,还可以对流量进行监控和统计。例如,它可以检测和防范 DDoS 攻击,并且能够收集服务器的性能数据,如每个服务器的负载情况、响应时间等。

🔳缺点

单点故障风险:如果负载均衡器出现故障,整个系统可能会瘫痪。虽然可以通过设置备份负载均衡器等冗余措施来降低风险,但这增加了系统的成本和复杂性。

增加网络延迟:请求需要经过负载均衡器转发,会增加网络跳数,从而可能导致网络延迟增加。在高并发或对延迟敏感的应用场景中,这可能会影响用户体验。

性能瓶颈风险:在处理大量请求时,负载均衡器本身可能会成为性能瓶颈。因为它需要消耗资源来处理请求的分析、分配和转发,可能会出现负载均衡器无法及时处理所有请求的情况。

🔳应用场景

传统的 Web 应用服务器集群:在企业级的 Web 应用中,如大型公司的官网、新闻网站等,通过服务端负载均衡器将用户浏览器的请求分配到后端的 Web 服务器集群,方便管理和维护服务器。

多层架构的系统入口:在多层架构的系统(如包含 Web 服务器、应用服务器、数据库服务器等)的入口处设置服务端负载均衡器,将外部请求合理地分配到不同层次的服务器上,保障系统的稳定性和性能。

需要集中管理和安全防护的系统:对于需要集中管理负载均衡策略、进行安全监控和过滤恶意流量的系统,如金融机构的网上银行系统、云服务平台等,服务端负载均衡器可以作为安全和管理的重要工具。